排序

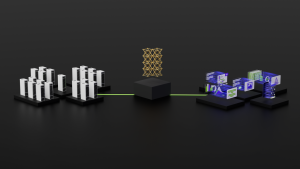

NVIDIA H100 GPU 於 MLPerf 首次亮相即創下生成式 AI 新標竿, CoreWeave 的 H100 GPU 集群在 11 分鐘完成 GPT-3 模型訓練

在 AMD 、 Intel 仍將 AI 性能指標的對照組放在前一世代的 NVIDIA A100 ,新一代的 NVIDIA H100 已經蓄勢待發; NVIDIA 宣布 NVIDIA H100 GPU 在 MLPerf 基準測試的首次亮相即位生成式 AI 樹立...

Snowflake 與 NVIDIA 合作,整合 NVIDIA NeMo 助企業於 Snowflake 資料雲打造自定義大型語言模型

現在許多企業皆希望能導入客製化的大型語言模型,作為進行數位轉型或是加速特定流程的手段,不過若企業從無到有建立大型語言模型需要花費漫長的時間,但隨著 NVIDIA 與多家知名雲服務商攜手提供...

結合 PyTorch 2.0 與 ROCm 5.4 的 AMD Instinct MI250 已在大型語言模型逐漸追上 NVIDIA A100

受到 NVIDIA 先期投入市場的軟硬體優勢, AMD 的 Instinct MI200 加速器系列雖獲得美國橡樹嶺實驗室新一代超級電腦 Frontier 採用,但市場討論度則仍較 NVIDIA 來的少;不過 AMD 也正努力的持續...

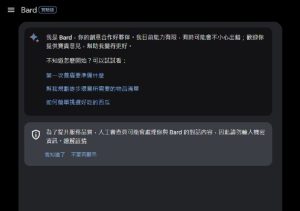

Google Bard 對話式 AI 服務開放支援包括繁體中文在內 40 語言,同步追加功能更新

Google 宣布自 2023 年 7 月起使對話式 AI 服務 Bard 支援包括繁體中文等 40 種語言,並進行多項功能更新,其中包括更個人化回覆,提升生產率與效率等等,借助擴大語系支援,使全球更多 G...

高通宣布與 Meta 合作強化終端 AI 技術,自 2024 年起為旗艦智慧手機與 PC 提供 Llama 2 大型語言模型技術

高通積極推廣混合式 AI 概念,並強調借助使終端設備具備更強大的 AI 性能,能夠縮減使用延遲並提升個人隱私;高通在 2023 年的 Snapdragon Summit 前夕宣布與 Meta 合作,雙方將針對使邊際設備...

高通專文介紹NPU之於裝置端執行生成式AI的意義,並強調透過異構運算能最大限度提升效能、能源效率

雖然行動裝置結合AI技術已經不是新聞,然而隨著生成式AI引領新一代AI技術,使AI不再只是作為單純的辨識與增強,而是能夠與使用者深度互動的技術,裝置端AI技術也邁入全新的局面,同時處理器產業...

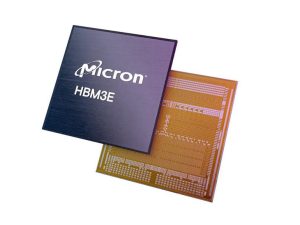

美光8層堆疊24GB HBM3e記憶體正式量產,NVIDIA H200 Tensor Core GPU率先採用

美光Micron宣布兼具高效能、大容量且更節能的HBM3e記憶體已正式量產,同時NVIDIA H200 Tensor Core GPU為首款宣布採用美光8層堆疊的24GB HBM3e解決方案的產品,並於2024年第二季出貨。同時美光...

美光宣布9x13mm封裝UFS 4.0行動儲存解決方案已送樣,採232層3D NAND、容量達1TB

美光Micron於MWC宣布其業界最小尺寸UFS 4.0行動儲存解決方案已送樣,基於232層3SD NAND與先進封裝,在9x13mm大小的UFS封裝晶片可提供1TB容量,同時循環讀寫性能也獲得翻倍的提升,尤其對於生成...

聯發科創新基地開源釋出中英雙語Breeze-7B大型語言模型,支援雙語且繁中推論僅需Meta或Mistral一半時間

聯發科創新基地繼2023年初釋出全球第一款繁體中文文本的大型語言模型(LLM)後,在2024年3月宣布開源支援中、英雙語的MediaTek Research Breeze-7B大型語言模型,基於開源界熱門的Mistral模型,相...

Google強調以人才培育、強化社群、協助產業創新協助台灣發展AI,深耕台灣深化教育

Google在2024年3月中旬藉媒體春酒邀請包括Google台灣總經理林雅芳、Google台灣董事總經理馬大康及 Google Cloud台灣總經理柯淑芬等台灣Google高層,與媒體分享Google在全球與台灣的布局,其中強...