排序

傳NVIDIA會在2025年第一季推出GeForce RTX 5090、RTX 5080、RTX 5070 Ti與RTX 5070

根據市場預期,NVIDIA很快就會在2025年CES宣布採用Blackwell的GeForce RTX 50系列消費級顯示卡,根據Benchlife.info取得的可信內線消息,NVIDIA將會在2025年第一季推出4款GeForce RTX 50顯示卡...

NVIDIA Blackwell 晶片量產 AI 訓練方式改變不影響 GPU 需求

NVIDIA 宣布其新一代 Blackwell 架構加速晶片已全面量產,並強調即使 AI 模型訓練方式改變,市場對 GPU 的需求仍將持續增長。 在稍早公布截至10月底的2025財年第三季財報,NVIDIA表示上一季內營...

鴻海集團宣布將於高雄建構機於NVIDIA GB200 NVL72機架的AI超級電腦,預計超過90exaflips為台灣最強AI HPC

與NVIDIA關係密切的鴻海集團於2024年10月8日的鴻海科技日宣布將於高雄建構台灣最高性能的AI超級電腦,此專案為鴻海高雄超級運算中心,基於NVIDIA的Blackwell架構,預計基於NVIDIA GB200 NVL 72...

甲骨文聯手 NVIDIA 打造 Zetta 級別 OCI Supercluster 運算叢集

OCI Supercluster 預計 2025 年上半年推出,規模可擴充到使用 13 萬多顆「Blackwell」GPU,提供峰值可達 2.4 zettaflops 的人工智慧算力。 在甲骨文舉辦的Oracle Cloud World大會中,NVIDIA宣布...

Volvo EX 90導入NVIDIA DRIVE Orin平台,計畫後續加入DRIVE Thor平台與透過DGX進行先進AI訓練

Volvo Cars全新純電SUV車款EX90宣布自北美南卡羅來納州查爾斯出貨至美國經銷商,Volvo EX90藉由搭載NVIDIA DRIVE Orin提供250FOPS運算性能,不僅提供出色的先進輔助駕駛,也具備面向未來的擴充...

NVIDIA 「Blackwell」 顯示架構深入解析:兆級 AI 運算新紀元

NVIDIA 在 Hot Chips 2024 揭露 Blackwell 架構細節,包括 B100、B200 和 GB200 Superchip,強調提升 AI 運算效能、能源效率與組合彈性。 針對今年在GTC 2024期間揭曉的「Blackwell」顯示架構,...

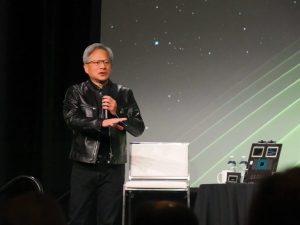

NVIDIA執行長黃仁勳將在6月2日於台大體育場舉辦COMPUTEX主題演講,6月5日另舉辦NVIDIA AI Summit Taiwan

先前在NVIDIA官方的行程已經確定NVIDIA執行長黃仁勳將於COMPUTEX 2024大會主題演講的前一日、也就是2024年6月2日晚間7點獨立舉辦COMPUTEX主題演講;NVIDIA官方正式公告黃仁勳的主題演講將選在台...

COMPUTEX 2024:NVIDIA展示Blackwell B200與B100加速器參考設計,明顯感受不同TDP設計對散熱器要求的變化

NVIDIA在COMPUTEX 2024期間依照往例於場外的飯店設置情境展示區,其中展示更接近量產的Blackwell平台組合,除了執行長黃仁勳在COMPUTEX 2024主題演講拿出的量產版本GB200模組,還包括在GTC 2024...

NVIDIA Hopper架構TensorRT-LLM使生成式AI推論提升近3倍,H200藉HBM3e記憶體散熱打破MLPerf推論紀錄

雖然NVIDIA甫在GTC 2024公布眾所矚目的全新Blackwell架構,但畢竟Blackwell仍要待到2024年下半年才會開始出貨,故目前最新的NVIDIA AI GPU加速產品為採用美光HBM3e記憶體的NVIDIA H200 Tensor C...

GTC 2024:黃仁勳強調運算產業將自資料中心邁入以生成式AI引領的AI Factory,Blackwell賣的是系統與生態系而非晶片

NVIDIA執行長黃仁勳在GTC 2024大會第二日的媒體團訪時,強調資料中心將面對巨大的轉型,借助GPU加速的生成式AI,他認為下一代的資料中心應該稱為AI Factory(AI工廠),透過AI技術產出各式的資源...