Intel 宣稱 Gaudi 3 加速器在訓練大型自然語言模型時,相比 NVIDIA H100 加速器可縮短 50% 訓練時間,而在推論速度方面則提升 30%,推論吞吐量則是提升 50%,推論電力損耗更降低 40%。

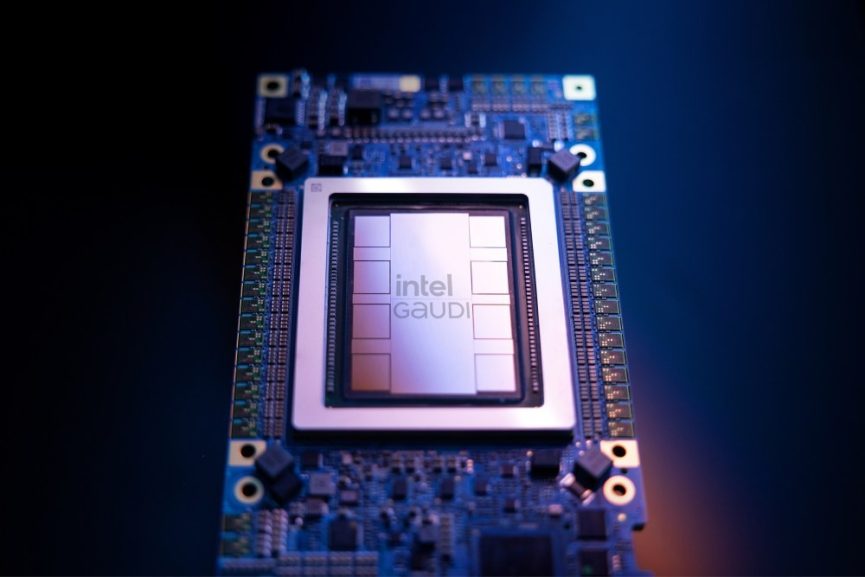

在Vision 2024大會上,Intel宣布推出Gaudi 3人工智慧加速器,相比前一代產品在BF16運算約提供4倍人工智慧效能,並且對應1.5倍記憶體傳輸頻寬與2倍網路傳輸頻寬,藉此實現擴充更大規模人工智慧運算,並且加速大型自然語言模型與多模態模型的人工智慧訓練,以及推論運算效率。

英特爾執行副總裁暨資料中心與AI解決方案總經理Justin Hotard表示:「AI市場瞬息萬變,但產品間仍存在巨大差距。不論是來自客戶還是更廣泛市場的回饋,皆反映對更多選擇的渴望。企業須權衡可用性、可擴充性、效能、成本和能源效率等因素。Intel Gaudi 3作為生成式AI的新選擇,憑藉性價比、系統可擴充性和時間成本優勢的完美結合脫穎而出。」

Gaudi 3加速器專為高效的大規模人工智慧運算需求打造,採用5nm製程生產,其設計允許同時啟動所有引擎,藉此提升包含矩陣乘法引擎 (MME)、張量處理器核心 (TPC),以及網路介面卡 (NIC)等整體運算速度,並且實現更高速、高效的深度學習運算與規模擴充。

而藉由專屬異質運算引擎設計,Gaudi 3加速器由64個人工智慧自訂與可編程張量處理器核心,加上8個矩陣乘法引擎構成,每個Gaudi 3的矩陣乘法引擎均能執行64000組平行運算,並且對應高效率的複雜矩陣運算,並且支援FP8和BF16在內多種資料類型。

為了符合大型自然語言模型運算需求,Gaudi 3加速器搭載128GB的HBMe2記憶體容量、3.7TB的記憶體頻寬,以及96MB的on-board靜態隨機存取記憶體。另外,每組 Gaudi 3加速器均整合24組傳輸量可達200GB的乙太網路連接埠,藉此實現高效擴充、支援大型運算集特性,可對應單一節點至超過1000個節點擴充能力。

另外,Gaudi 3加速器可藉由Gaudi軟體整合PyTorch框架,並且可使用託管於Hugging Face社群的最佳化模型,藉此對應常見自動生成式人工智慧框架,並且可提升人工智慧佈署易用性與生產力,同時也能快速將模型移轉到不同硬體使用。

除了推出一般版本,Gaudi 3加速器更額外提供PCIe版本,本身以600W熱設計功耗封裝,並且整合128GB記憶體容量,對應每秒可3.7TB的資料傳輸頻寬。

相比NVIDIA推出的H100加速器,Intel標榜Gaudi 3加速器在Llama2 7B與13B參數規模,以及GPT-3 175B參數規模模型的訓練時間可縮減50%,而在Llama 7B與70B參數規模,以及Falcon 180B參數模型上的推論速度提升30%,推論吞吐量則是提升50%,推論電力損耗更降低40%,同時在較長的輸入和輸出序列中,更具有明顯的推理效能優勢。

Intel將於今年第二季開始向OEM業者提供基於Gaudi 3加速器的通用基板與開放加速器模型 (Open accelerator module, OAM)的標準配置,而包含戴爾、HPE、聯想與Supermicro等OEM業者都將採用Gaudi 3加速器打造應用設備。

至於Gaudi 3加速器預計於今年第三季全面上市,Gaudi 3 PCIe版本則預計於今年第四季上市。

暂无评论内容