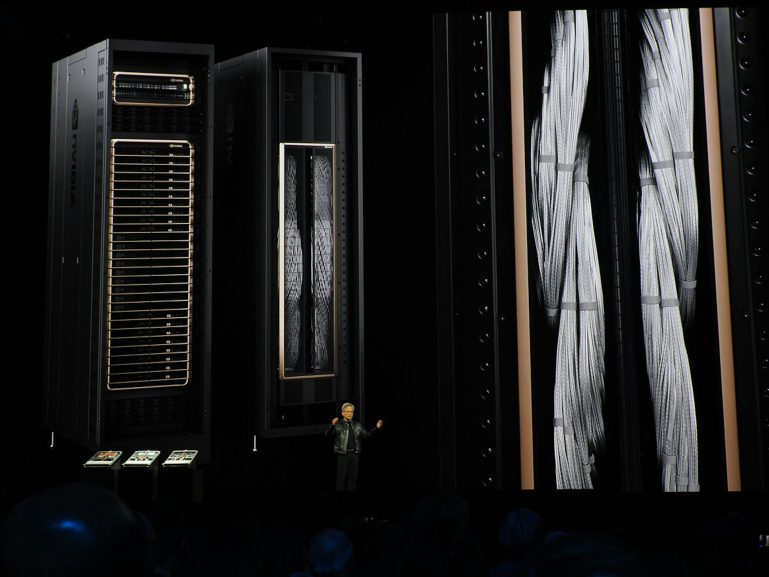

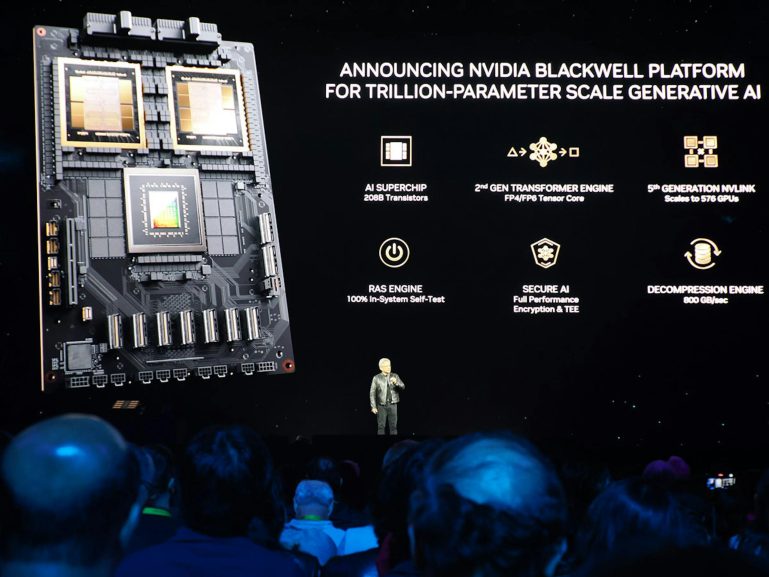

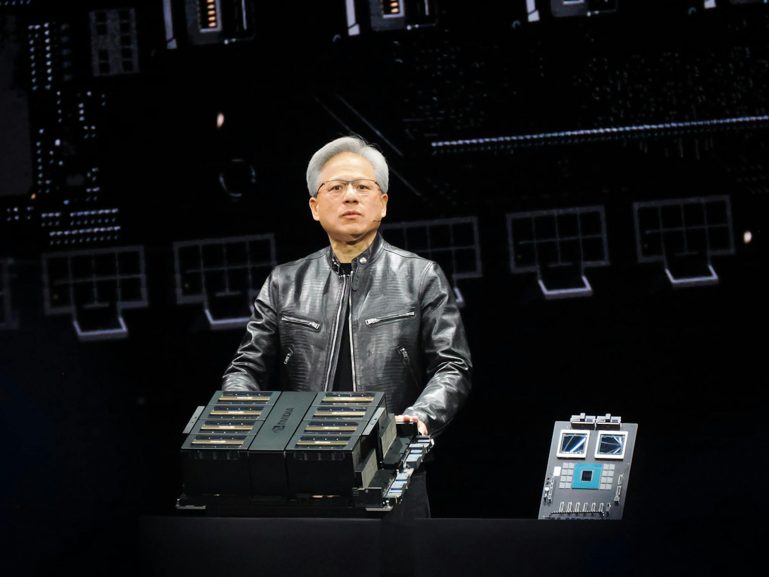

NVIDIA於GTC 2024公布Blackwell架構,也同步宣布基於Blackwell GPU的新一代NVIDIA DGX SuperPOD;不同過往DGX SuperPod採用x86架構與風冷散熱,基於Blackwell架構新DGX SuperPod採用基於Arm Neoverse的Grace CPU與Blackwell GPU構成的NVIDIA GB200 Superchip,並採更高效的液冷散熱架構,透過NVLink可連接至最多576個Blackwell GPU,借助NVIDIA網路、NVIDIA全端AI軟體與儲存最高可擴展數萬個GB200 Superchip,可因應兆級規模的AI超級運算。NVIDIA也同步公布傳統風冷機架式的DGX B200,同樣可構建DGX SuperPod。

搭載DGX GB200與DGX B200的NVIDIA SuperPod預計2024年稍晚由NVIDIA全球合作夥伴提供

▲DGX GB200為GB200 NVL72液冷機架,內部的節點以NVLink進行高速連接宛若單一大型GPU

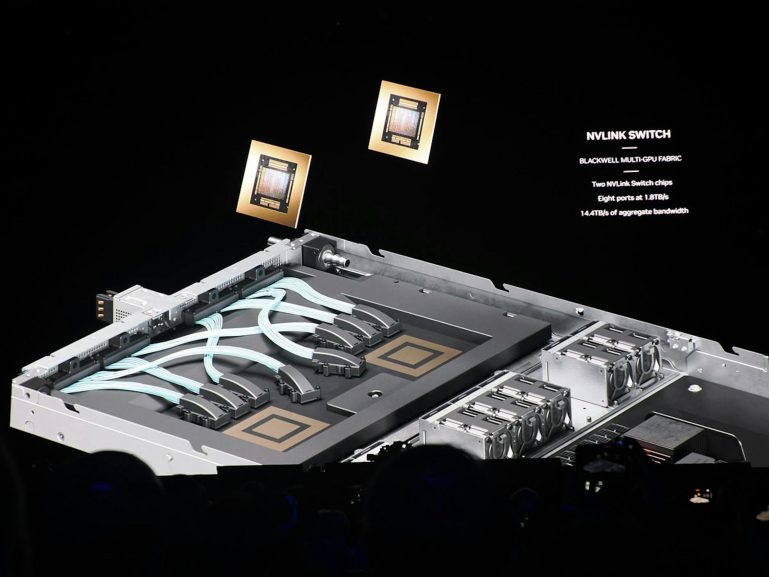

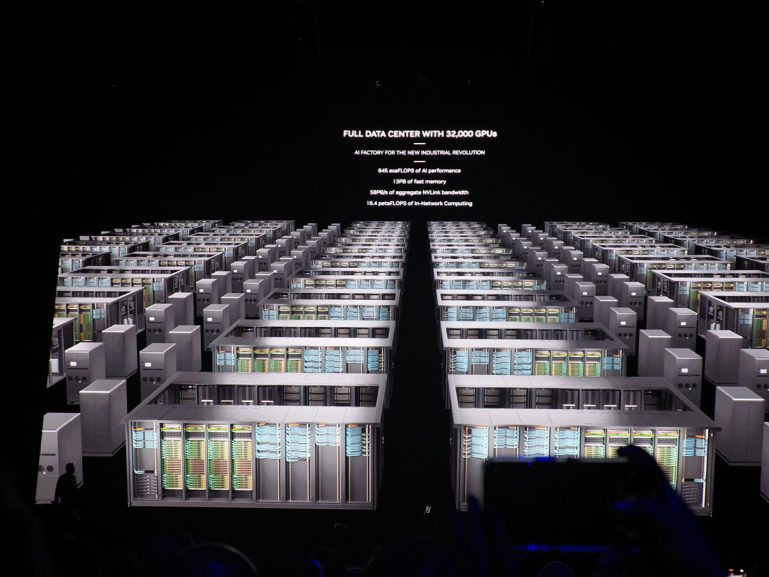

構成新一代DGX SuperPod基礎的DGX GB200採用GB200 NVL72液冷機架系統,具備36個NVIDIA GB200 Superchip,彼此以第5代NVLink連接,以8個或以上的DGX GB200建構,並利用Quantum InfiniBand連接到數萬個GB200 SuperChip,若為了下一代AI模型提供充裕的共享記憶體,可透過以NVLink將8個DGX GB200系統的576個Blackwell連接,構成一個具備240TB快速記憶體;11.5exaflops FP4精度AI算力的系統。

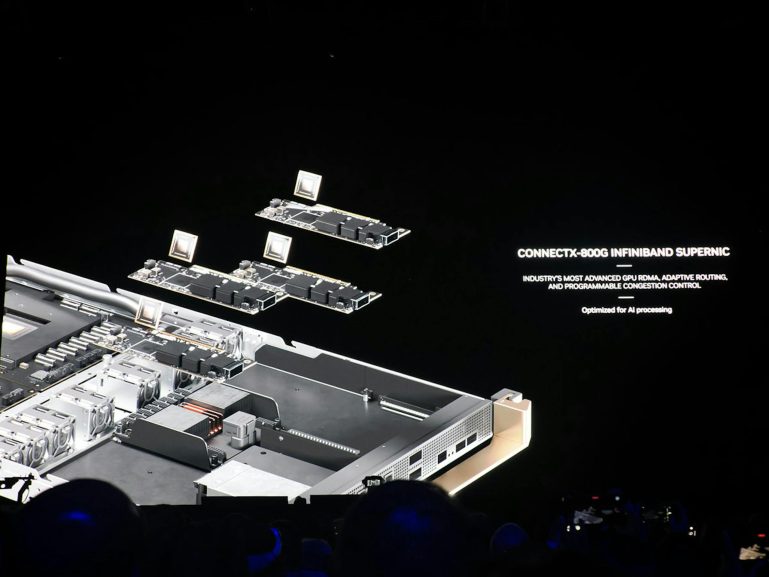

▲DGX GB200採用ConnectX-800G InfiniBand

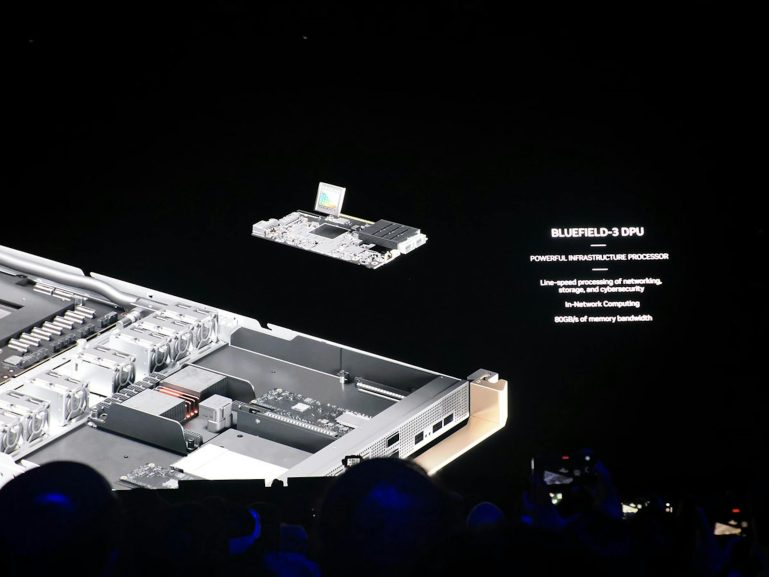

▲同時透過BlueField-3 DPU提供網路內運算

▲NVSwitch是使多個節點大量GPU得以高速連接並共享記憶體的重要關鍵

採用DGX GB200為基礎的DGX SuperPOD具備統一運算架構,結合第5代NVLink,還有NVIIDA BlueField-3 DPU,與支援NVIDIA Quantum-X800 InfiniBand網路,可提供平台內的每個GPU達1,800GB/s的頻寬,並透過SHARPv4提供14.4teraflops的網路內運算能力。

▲借助Blackwell的智慧預測能夠降低停機頻率,能延長連續執行時間並提高可靠度進而降低營運成本

借助Blackwell架構具備智慧預測管理,透過持續監控硬體與軟體等資料點,預測攔截停機與低效率根源,甚至不須管理員在場級可識別問題領域與規劃維護工作,靈活調度運算資源並自動儲存與恢復工作,進而有效提升能源效率、運算成本與可靠性;若測到需更換組件,叢集將啟動備用容量確保工作完成,使任何需要置換的硬體可預先安排,避免非計畫性停機。

▲NVIDIA DGX B200也同樣能建構DGX SuperPod

除了NVIDIA DGX GB200,NVIDIA也提供為AI模型訓練、微調、推論的傳統機架式DGX設計的DGX B200,DGX B200為NVIDIA第六代風冷機架式DGX系統,可提供8個以NVLink連接的NVIDIA B200 Tensor Core GPU與兩顆第5代Xeon Scalable處理器,配有8個NVIDIA ConnectX-7NIC與兩個BlueField-3 DPU,同樣也能建構DGX SuperPod;借助Blackwell支援FP4精度,具備144 Pflops的AI效能,與1.4TB GPU記憶體、64TB/s的記憶體頻寬,相較DGX H100進行即時推論兆級參數模型快上15倍。

暂无评论内容