- Amazon EC2 Hpc7g 執行個體採用最新款的 AWS Graviton3E 處理器,為高效能運算工作負載提供極佳的性價比

- Amazon EC2 C7gn 搭配新一代 AWS Nitro,具有增強的網路處理能力,是目前 Amazon EC2 網路優化型執行個體中,提供最高網路頻寬和網路封包處理效率的執行個體

- Amazon EC2 Inf2 執行個體採用最新款的 AWS Inferentia2 機器學習加速推論晶片,在 Amazon EC2 上以最低延遲與成本,大規模執行大型的深度學習模型

在 AWS re:Invent 年度盛會上,Amazon Web Services(AWS)宣布推出三款分別由三種新的自研晶片支援的Amazon Elastic Compute Cloud(Amazon EC2)執行個體,為客戶廣泛的工作負載提供更高的性價比。Hpc7g 執行個體搭配 AWS 自研的最新 Graviton3E 處理器,與前一代 C6gn 執行個體相比浮點效能提高 2 倍,與前一代 Hpc6a 執行個體相比效能提高 20%,為 AWS 上的高效能運算工作負載提供超高性價比。配備新一代 AWS Nitro的C7gn 執行個體,與前一代網路優化型執行個體相比,為每個 CPU 分別提供多達 2 倍的網路頻寬和 2 倍的每秒網路封包效率(packet rate)效能,為網路密集型工作負載提供超高的網路頻寬、網路封包效率效能和性價比。Inf2 執行個體搭配 AWS 自研的最新 Inferentia2 機器學習加速推論晶片,是一個專門為執行多達 1,750 億個參數的大型深度學習模型而建構的,與前一代 Inf1 執行個體相比可提供高達 4 倍的吞吐量,降低高達 10 倍的延遲,以最低的成本為 Amazon EC2 上的機器學習推論提供最低延遲。

AWS 擁有十多年晶片設計經驗,在雲端中以更低成本實現更高效能和可擴展性。十多年來,AWS 推出多種客製化的晶片設計,也幫助客戶執行要求更高效能的工作負載,包含更快的處理速度、更高的記憶體容量、更快的儲存 I/O 和更高的網路頻寬。AWS 自 2013 年推出 AWS Nitro 系統以來,已經開發多個自研晶片,包括五代 Nitro 系統、致力為各種工作負載提升效能和優化成本的三代 Graviton 晶片、用於加速機器學習推論的兩代 Inferentia 晶片,以及用於加速機器學習訓練的 Trainium 晶片。AWS 在晶片設計和驗證的敏捷開發週期中使用以雲端為基礎的電子設計自動化 (Electronic Design Automation – EDA),使團隊能夠更快地進行創新,也能更快地將晶片提供給客戶。 AWS 更現代化、更節能的半導體處理確保晶片的快速反覆運算及交付。每推出一款新的晶片,AWS 都進一步提升這些晶片支援的 Amazon EC2 執行個體的效能、效率以及更優化的成本,為客戶提供更多的晶片和執行個體組合選擇,針對他們不同的工作負載進行優化。

AWS Amazon EC2 副總裁 David Brown 表示:「從 Graviton 到 Trainium、Inferentia 再到Nitro,AWS 每一代自研晶片都為客戶的各種工作負載提供更高效能、更優化的成本和更好的能源效率。持續的投入讓我們的客戶獲得卓越的性價比,並反過來推動 AWS 不斷地創新。我們今天推出的 Amazon EC2 執行個體為高效能運算、網路密集型工作負載和機器學習推論工作負載提供顯著的效能提升,客戶也因此有更多的執行個體選擇來滿足他們的特定需求。」

Hpc7g 執行個體專為在 Amazon EC2 上大規模執行高效能運算工作負載提供超高性價比

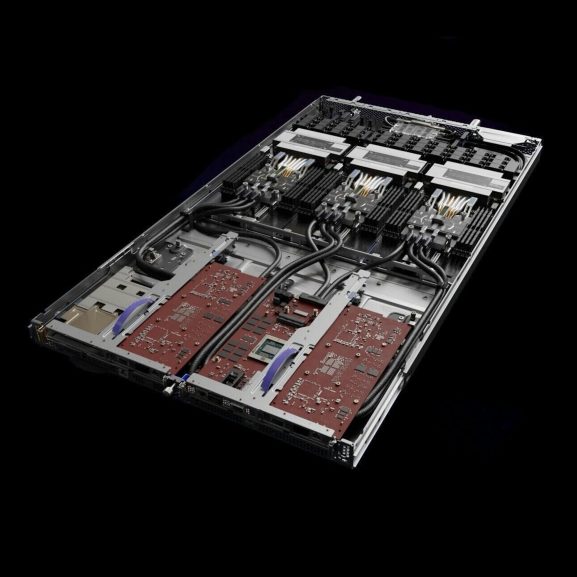

▲Amazon EC2 C7gn 執行個體/Photo Credit:Amazon Web Services (AWS)

▲Amazon EC2 C7gn 執行個體/Photo Credit:Amazon Web Services (AWS)

很多領域的組織需要依靠高效能運算來解決複雜的學術、科學和商業問題。現今許多客戶如阿斯特捷利康(AstraZeneca)、Formula 1 一級方程式賽車、Maxar Technologies 衛星影像科技等,皆在 AWS 上借助 AWS 提供的卓越安全性、可擴展性和彈性,執行傳統的高效能運算工作負載,包括基因組學處理、計算流體動力學和天氣預報模擬等。工程師、研究人員和科學家使用 Amazon EC2 高效能運算優化型執行個體如 Hpc6a、Hpc6id、C5n、R5n、M5n 和 C6gn,執行高效能運算工作負載,這些執行個體提供近乎無限的運算能力和伺服器之間的高網路頻寬,實現數千個核心處理和資料交換。雖然這些執行個體的效能足以滿足目前大多數高效能運算場景,但人工智慧和自動駕駛汽車等新興應用需要高效能運算優化執行個體,可以擴展到數萬個甚至更多的核心,進一步解決難度持續增加的問題並降低高效能運算工作負載的成本。

Hpc7g 執行個體由新的 AWS Graviton3E 晶片提供支援,為客戶在 Amazon EC2 上的高效能運算工作負載如計算流體力學(computational fluid dynamics,CFD)、天氣模擬、基因組學和分子動力學等,提供超高的性價比。與採用 Graviton2 處理器的前一代 C6gn 執行個體相比,Hpc7g 執行個體的浮點效能提高 2 倍;與前一代 Hpc6a 執行個體相比,效能提高 20%,讓客戶能夠在多達數萬個核心的高效能運算叢集中進行複雜的運算。Hpc7g 執行個體也提供高記憶體頻寬和所有 AWS 執行個體類型中最高的每 CPU 網路頻寬,可以更快的執行並完成高效能運算應用。客戶可以透過開源的叢集管理工具 AWS ParallelCluster 使用 Hpc7g 執行個體,與其它執行個體類型一起配置 Hpc7g 執行個體,讓客戶在同一個高效能運算叢集中靈活執行不同的工作負載類型。欲瞭解更多資訊,請參閱此連結。

C7gn 執行個體為網路密集型工作負載提供極佳效能,具有更高的網路頻寬、更高的分封速率效能和更低的延遲

客戶使用 Amazon EC2 網路優化型執行個體執行要求極為嚴苛的網路密集型工作負載,如網路虛擬化設備(包含防火牆、虛擬路由器和負載等化器等)和資料加密業務等。客戶需要為這些工作負載擴展效能,以處理不斷增加的網路流量來應對業務高峰,或者縮短處理時間為終端使用者提供更好的體驗。現在,為獲得更多網路傳輸量,客戶採用更大型號的執行個體,部署遠高於需求的運算資源,也因此增加成本。客戶為了減少資料處理的時間,需要更高的分封速率效能、更高的網路頻寬以及更快的加密效能。

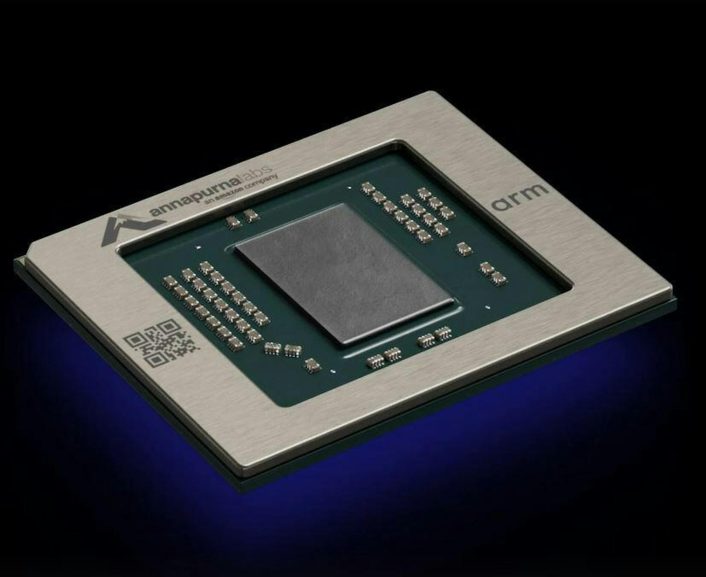

C7gn 執行個體採用新的、具有網路加速功能的第五代 Nitro,在 Amazon EC2 網路優化型執行個體中具有最高的網路頻寬和分封處理效能。Nitro 卡將主機 CPU 的輸入/輸出功能卸載到專用硬體並進行加速,將 Amazon EC2 執行個體的所有資源皆提供給客戶的工作負載,從而以更低的 CPU 利用率實現更穩定的效能。新款 AWS Nitro 卡使 C7gn 執行個體的每個 CPU 提供高達 2 倍的網路頻寬和 2 倍的每秒網路封包效能,與前一代網路優化型 Amazon EC2 執行個體相比,進一步降低Elastic Fabric Adapter(EFA)網路延遲。與 C6gn 執行個體相比,C7gn 執行個體提高多達25%的運算效能及多達 2 倍的加密效能。C7gn 執行個體透過擴展網路效能和傳輸量以及減少網路延遲,優化客戶在 Amazon EC2 上要求最嚴苛的網路密集型工作負載的成本。欲瞭解更多資訊,請參閱此連結。

▲第五代 AWS Nitro 晶片/Photo Credit:Amazon Web Services (AWS)

▲第五代 AWS Nitro 晶片/Photo Credit:Amazon Web Services (AWS)

Inf2 執行個體專為嚴苛的深度學習模型而設計,支援分散式推論和隨機捨入演算法

為提供更好的應用或者更加客製化的個人化體驗,資料科學家和機器學習工程師正在建構更大、更複雜的深度學習模型。例如越來越普遍且超過 1,000 億個參數的大型語言模型(LLM)需要海量的資料進行訓練,這也推動運算需求的空前增長。雖然訓練備受大家關注,但在生產環境中執行機器學習,大部分的複雜性和成本卻用在推論上,例如,每花1美元用於訓練,將有多達 9 美元用於推論。這限制推論的使用並阻礙客戶創新。客戶希望在應用中大規模使用先進的深度學習模型,但卻受限於高額的運算成本。當 AWS 在 2019 年推出 Inf1 執行個體時,深度學習模型具有數百萬個參數。此後,深度學習模型的規模和複雜性呈指數級增長,甚至有些深度學習模型的參數增長 500 倍,超過數千億個參數。致力於使用最先進的深度學習技術,開發新一代應用的客戶,希望擁有高性價比、高能源效率的硬體,實現低延遲、高吞吐量的推論以及靈活的軟體的支援,讓工程團隊能夠快速大規模地部署業務創新。

Inf2 執行個體搭配AWS自研的最新款 Inferentia2 機器學習加速推論晶片,可以執行高達 1,750 億個參數的大型深度學習模型如 LLM、影像生成和自動語音檢測,同時在 Amazon EC2 上提供最低的單次推論成本。Inf2 是第一個支援分散式推論的推論優化型執行個體,該技術將大型模型分佈在多個晶片上,為超過 1,000 億參數的深度學習模型提供極佳效能。Inf2 執行個體也是雲端第一個支援隨機捨入(stochastic rounding)的執行個體,這種以概率方式進行四捨五入的方式與傳統的四捨五入相比,能夠提供更高的效能和更高的精度。Inf2 執行個體支援廣泛的資料類型,包含可提高吞吐量並降低每次推論功耗的 CFP8,和可提升尚未利用到低精度資料類型模組效能的 FP32。客戶可以透過用於機器學習推論的統一軟體開發套件 AWS Neuron 開始使用 Inf2 執行個體。AWS Neuron 與 PyTorch 和 TensorFlow 等流行的機器學習框架組成,幫助客戶僅需少量程式碼改動就能將現有模型部署到 Inf2 執行個體。由於大型模型需要多個晶片支援,晶片之間需要實現快速通訊,Inf2 執行個體支援 AWS 的執行個體內部高速互連技術 NeuronLink,提供 192GB/s 的環形連接。與當前一代 Inf1 執行個體相比,Inf2 執行個體提供高達 4 倍的吞吐量,降低多達 10 倍的延遲,與基於 GPU 的執行個體相比,每瓦效能提升高達 45%。Inf2 執行個體目前提供預覽版,欲瞭解更多資訊,請參閱此連結。

Arup(奧雅納)是一家由設計師、工程與永續發展諮詢師、顧問和專家組成的國際企業,致力於實踐永續發展,並利用想像力、技術和嚴謹的態度來建造一個更美好的世界。奧雅納資深工程師 Sina Hassanli 博士說:「我們使用 AWS 的服務來執行高度複雜模擬,幫助我們的客戶建造新一代高層建築、體育場館、資料中心和關鍵基礎設施,同時對影響大家生活的城市微氣候、全球暖化和氣候變化進行評估並提供洞察。我們的客戶希望能以更低的成本進行更快、更準確的模擬,以便在開發的早期階段提供設計資訊。我們期待借助更高效能的 Amazon EC2 Hpc7g 執行個體,幫助客戶實現更快、更有效的創新。」

Rescale 為建構雲端軟體和服務的科技公司,幫助各種規模的組織實現工程和科學的突破,豐富人們的生活。Rescale 高效能運算副總裁 Mulyanto Poort 表示:「降低延遲和提高節點間網路效能對高效能運算應用至關重要。我們的客戶希望能擁有快速反覆計算流體力學快速迭代和改進產品設計的能力,他們除了關注雲端運算的效能和靈活性外,也越來越關心環境的永續性。我們很高興能看到 Amazon EC2 Hpc7g 執行個體具有的更多的浮點效能和更高的 EFA 頻寬。對於 Hpc7g 執行個體更高的性價比,以及 AWS Graviton 處理器的高能源效率非常期待,這將推動我們在模擬計算流體力學,以及生產領域高效能運算進一步發展。」

本文章內容由「Amazon Web Services (AWS)」提供。

暂无评论内容