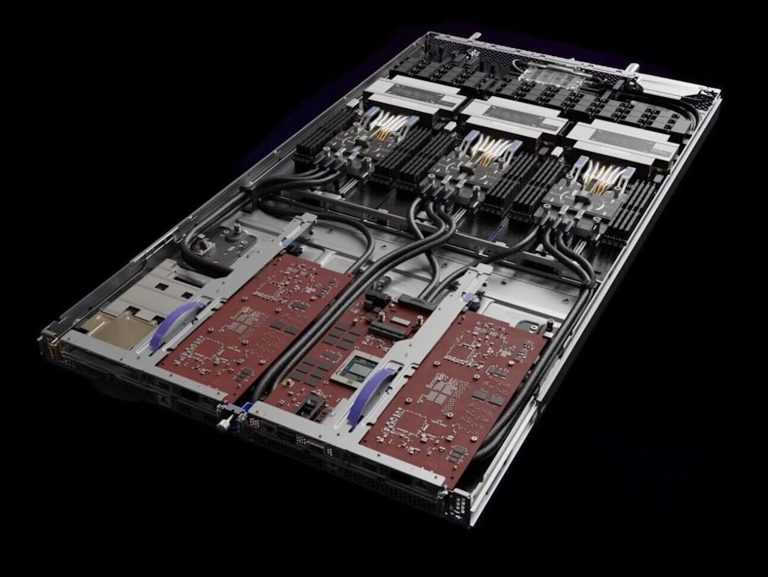

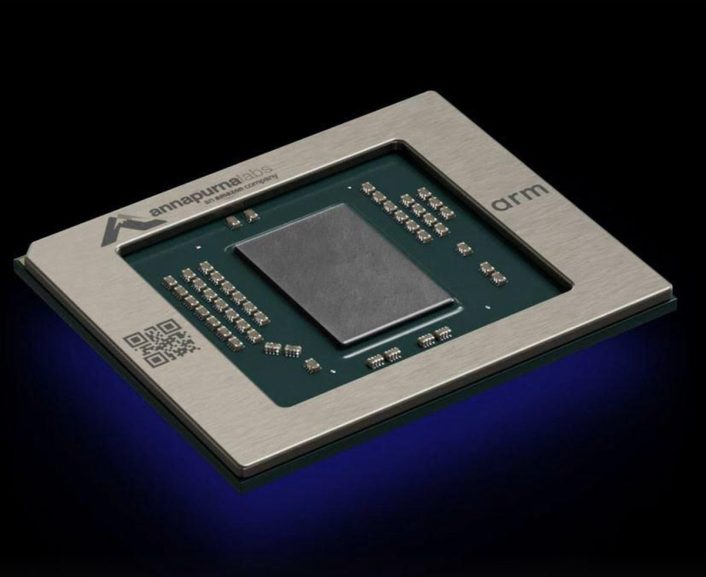

亞馬遜旗下 AWS 宣布推出由 AWS 自研三款晶片的三款全新 Amazon EC2 執行個體,包括採用針對高效能運算的 Amazon Graviton3E 的 Amazon EC2 Hpc7g ,著重增強網路頻寬與封包處理能力的 Amazon Nitro 的 Amazon EC2 C7gn ,以及專業機器學習加速推論的 Amazon Inferentia2 所驅動的 Amazon EC2 Inf2 ,以差異化的晶片設計滿足不同應用領域的運算需求。

其中 Hpc7g 執行個體所搭載的 Gravition3E 處理器,相較 C6gn 執行個體的處理器福點運算效能提高 2 倍,並帶來 20% 整體效能提升,為高效能運算工作負載帶來超高性價比;而採用 Amazon Nitro 的 C7gn 則較前一代網路優化型執行個體,每個 CPU 分別提供多達 2 倍網路頻寬與 2 倍的每秒網路封包效率; Inf2 執行個體所具備的 Inferentia2 機器學習加速推論晶片對比 Inf1 執行個體具備 4 倍吞吐論,並降低 10 倍延遲,能夠為機器學習推論帶來低成本且低延遲的體驗。

AWS 投入自研晶片已有長達 10 年的經驗,也是積極將 Arm 指令集 CPU 導入雲端伺服器的先驅者,借助自研方式,因應不同領域打造多種客製化晶片設計,協助客戶在不同的應用模式具備更高效能且具經濟效益的工作負載,當前在網路處理的 Nitro 晶片已經自 2013 年的第一代如今邁進到第 5 世代,而鎖定高效能運算的 Graviton 也進入第三代設計,著重在機器學習推論的 Inferentia 則推出第二世代產品。

AWS 強調在十年的晶片設計經驗與驗證,透過以雲端為基礎的電子設計自動化( EDA ),使開發團隊能夠快速進行創新,並更快完成設計與交付給客戶,同時 AWS 依但完成一款新晶片,即會進一步提升這些晶片所支援的 Amazon EC2 執行個體效能、效率,提供客戶更多晶片與執行個體組合選擇,因應客戶不同工作負載的最佳化組合。

▲ AWS 投入自研晶片已有 10 年的經驗,並逐步針對不同的應用需求開發專屬的自研晶片產品

其中針對高效能運算的 Hpc7g 執行個體已廣泛倍用以解決學術、科學與商業問題,諸如 AstraZeneca Formula 1 一級方程式車隊、 Maxar Technologies 等皆透過 AWS EC2 執行個體進行如基因組學處理、流體力學與天氣預報,透過 AWS EC2 的彈性化,一旦需要更高效能的運算資源,可擴展到數萬個甚至更多核心。

至於 C7gn 執行個體是以處理網路密集型工作負載為目的,包括像是防火牆、虛擬路由器、負載等化器、資料加密業務等網路虛擬化設備相關領域,第五代 Nitro 晶片即是具備網路加速功能的新一代 AWS 自研晶片,能夠把主機 CPU 的輸入與輸出功能進行卸載並加速,使 Amazon EC2 執行個體的 CPU 資源集中在客戶的工作負載,減少處理大量網路資料輸出入對 CPU 的負擔。

而 Inf2 執行個體則是著重在深度學習模型的推論應用,可支援分散式推論與隨機捨入演算法,是為了解決當前進行大型深度學習模型與大型語言模型 LLM 的情況,解決目前這類人工智慧應用將大部分複雜性與成本用於推論的情形,降低推論所產生的成本,使客戶能把更多的成本投入到前端的模型訓練; Inf2 所使用的 Inferentia2 機器學習加速推論晶片可執行達 1,750 億個躥樹的大型深度學習模型,舉凡自 LLM 、影像生成到自動語音檢測,同時是首款在雲端具備支援隨機捨入的推論晶片,此外還支援可提升吞吐論與降低功耗的 CFP8 資料類型以即可提升尚未利用到低精度資料類型模組效能的 FP32 ,且借助 AWS 執行個體內部高速互聯技術 NeuroLink 提供達 192GB/s 的晶片對晶片環狀連接,帶來低延遲、高吞吐量的分散式推論,並藉此提供最低的單次推論成本。

暂无评论内容